Marco, wie verwendet man ChatGPT & Co. eigentlich „richtig"?

Antwortmaschine vs. Co-Intelligenz

Vor drei Jahren wollten in meinen Workshops noch viele wissen, was diese Tools überhaupt können, heute geht es meinen Teilnehmenden immer häufiger darum, wie man sie so verwendet, damit sie wirklich helfen und nicht schaden.

Die aktuelle Studienlage zeigt ein gemischtes Bild. KI steigert Produktivität und Geschwindigkeit¹, verbessert die Teamarbeit² und macht vielen bei der Verwendung Spaß³. Gleichzeitig warnen Forschende, dass kritisches Denken⁴, Lernfähigkeit⁵ und kognitive Leistungen⁶ leiden können, wenn wir uns zu sehr auf diese Tools verlassen. Doch fast alle dieser Studien haben eine Gemeinsamkeit. Sie zeigen, dass es entscheidend auf die richtige Nutzung ankommt. Viele der beobachteten negativen Effekte lassen sich deutlich abschwächen oder sogar vermeiden, wenn wir die Tools bewusst einsetzen. Gleichzeitig entstehen viele der positiven Effekte erst dann, wenn wir sie gezielt und reflektiert verwenden.

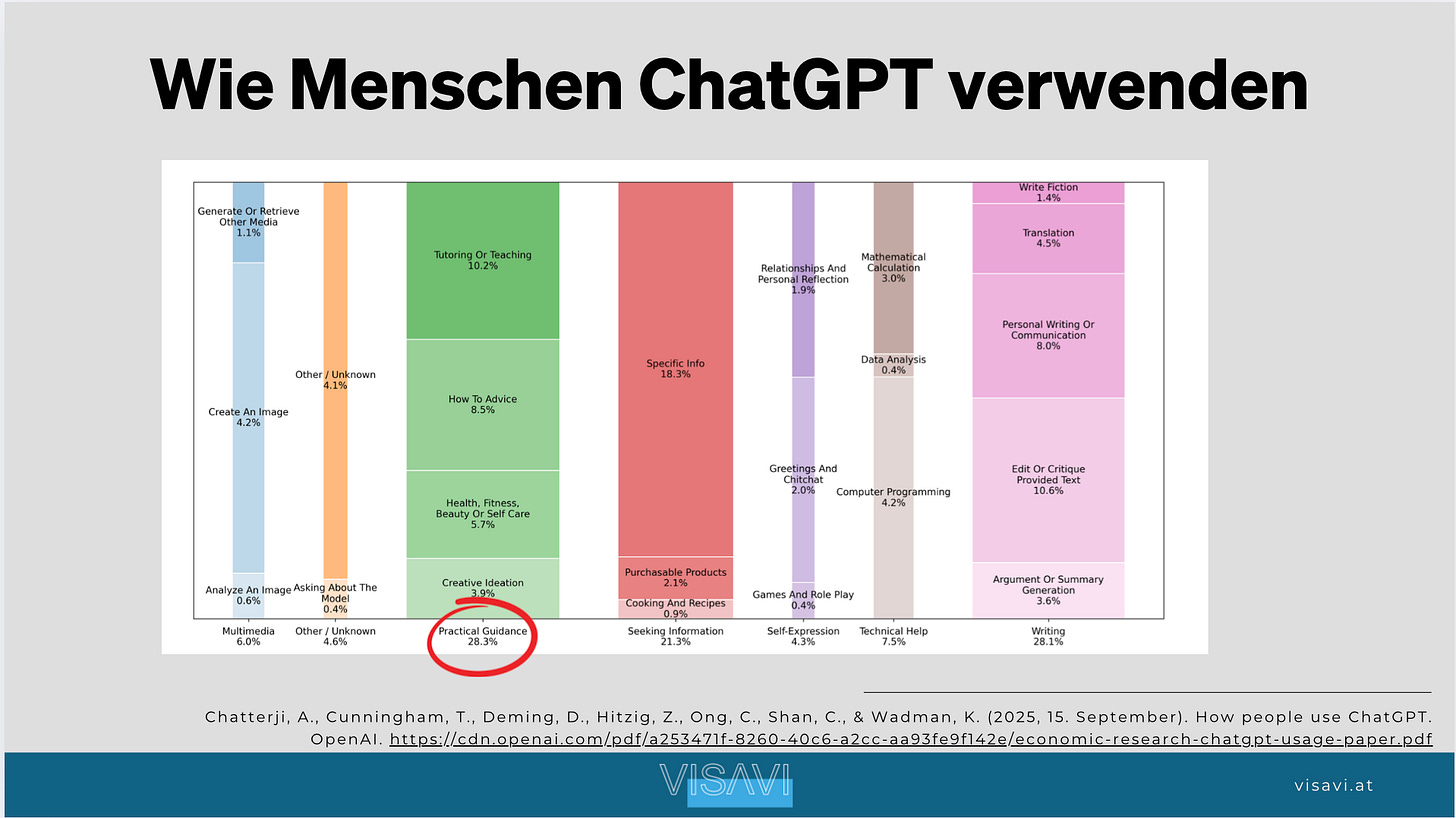

Eine neue Analyse⁷ von OpenAI selbst zeigt außerdem, dass sich die Nutzung klar verschiebt. Diese Tools werden immer stärker in den privaten Alltag integriert. Mehr als 70% aller Nachrichten sind inzwischen nicht mehr arbeitsbezogen, sondern für den privaten Gebrauch gedacht. Auch die Geschlechterverteilung gleicht sich mittlerweile aus, Frauen nutzen ChatGPT inzwischen genauso intensiv wie Männer.

Gleichzeitig werden die Tools selbst nahtloser in unser Leben eingebettet. Claude kann mittlerweile auf unserem Smartphone auf unseren Kalender und Nachrichten zugreifen⁸, Perplexity kann mit unseren E-Mails interagieren⁹ und ChatGPT hat mittlerweile eine integrierte Shopping-Funktion¹⁰. Gerade weil diese Systeme sich so selbstverständlich in unseren Alltag schieben, wird die bewusste und „richtige“ Nutzung entscheidend.

Daher hier ein paar Empfehlungen aus der Praxis:

Die Basics

Um einzusteigen, braucht es fast nichts. Wer einen Google-Account hat, kann sich bei allen gängigen Modellen registrieren und erhält Zugang zur Welt der generativen KI. Die meisten Personen aus meinen Workshops und Vorträgen haben mittlerweile schon mit ChatGPT & Co. herumexperimentiert, allerdings mit den Gratis-Versionen. Die kostenlosen Versionen sind jedoch oft eher Demos als vollwertige Werkzeuge und vermitteln ein verzerrtes Bild davon, was KI heute schon leisten kann. Daher lohnt es sich, zumindest einmal eine kostenpflichtige Version auszuprobieren (bei den meisten Anbietern ca. 20 €). Ich empfehle zum Start gerne ChatGPT als „eierlegende Wollmilchsau”. Am Ende ist es egal welcher Anbieter, wer die Tools richtig einsetzen kann, bekommt den günstigsten Mitarbeitenden/Assistenten, den man sich vorstellen kann.

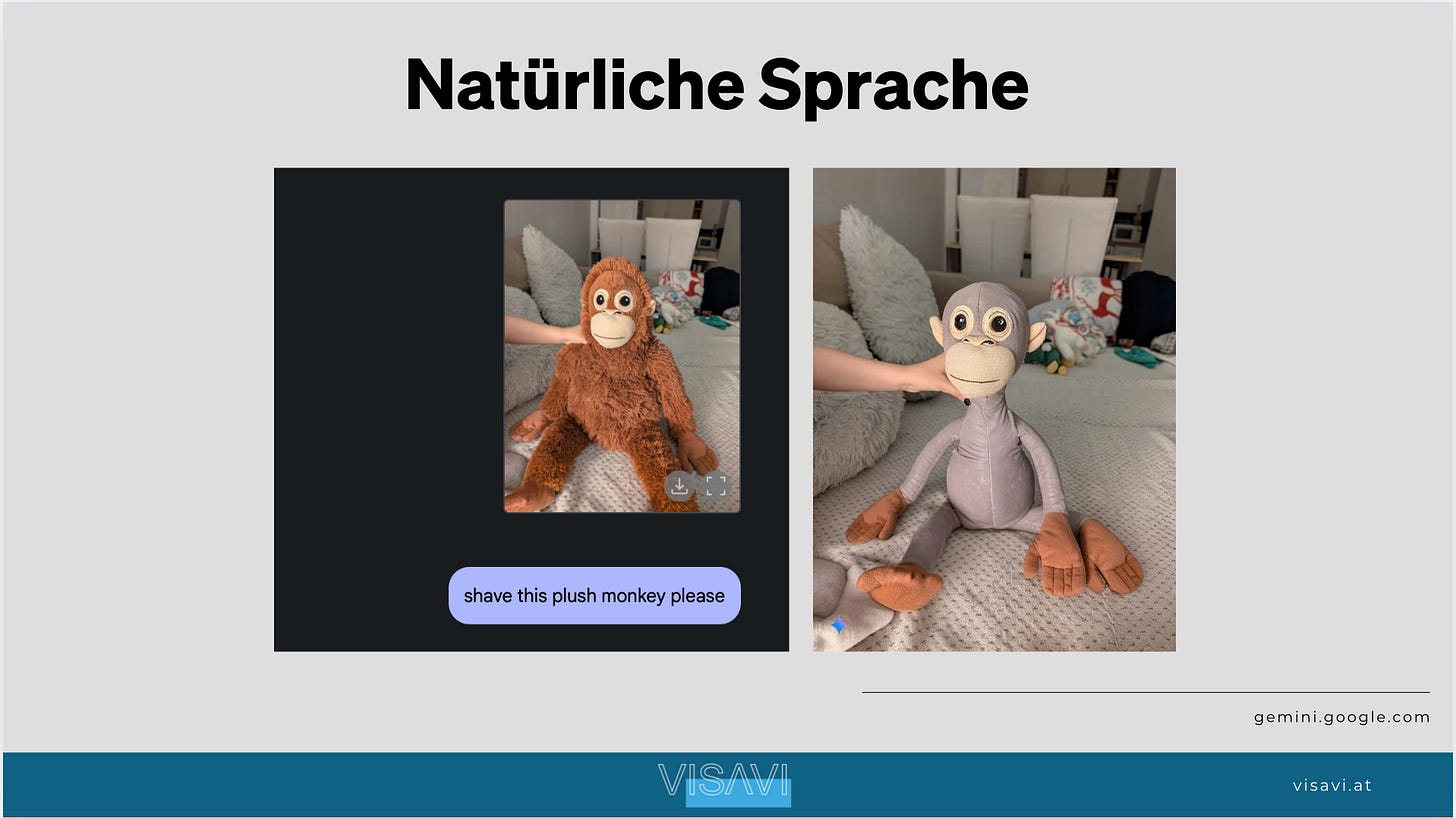

Auch die Interaktion mit ChatGPT und Co. ist erstaunlich einfach. Diese Tools basieren auf menschlicher Sprache und lassen sich ohne technisches Vorwissen bedienen. In meinen Workshops hat das klassische „Prompting“ (also die Kommunikation mit diesen Tools) immer weniger Gewicht bekommen, weil viele alte Prompting-Tricks heute kaum noch nötig sind. Bitte und Danke schreiben, der KI ein fiktives Trinkgeld versprechen oder sie mit dem Ausschalten bedrohen, das war mal lustig und teilweise sogar hilfreich, ist heute aber nicht mehr notwendig¹¹. Die Modelle sind inzwischen so gut darin, uns Menschen zu verstehen, dass es vor allem darauf ankommt, ganz normal und menschlich mit ihnen zu sprechen. So wie man auch mit einer Kollegin oder einem Kollegen sprechen würde.

Dabei ist es jedoch wichtig zu verstehen, dass diese Tools keine Menschen sind und auch keinen Menschenersatz darstellen, aber sie funktionieren nun mal am besten, wenn man mit ihnen wie „Menschen” kommuniziert - also möglichst spezifisch, mit dem nötigen Kontext und klaren Zielen.

Tipp: Startet doch mal mit diesem einfachen Prompt: Stell mir 5 Fragen zu meinen Interessen und Arbeitsaufgaben, damit du verstehst, wie du mir am besten helfen kannst.

Auch die Video-Generierung¹² wird immer intuitiver: Man kann direkt in die Szene zeichnen oder Anmerkungen hinzufügen. Das Modell versteht die Hinweise und setzt sie um. (Videomodell: VEO3)

Man muss auch keine Angst vor technischen Einstiegsschwierigkeiten haben. In meiner Masterarbeit¹³ habe ich mich intensiv mit den Mechanismen beschäftigt, die digitale Plattformen einsetzen, um uns an die Bildschirme zu fesseln. Ich kann euch daher garantieren, dass OpenAI und Co. jede Menge dieser Mechanismen verwenden, um die Nutzung so leicht wie möglich zu gestalten. Das ist für uns ein Vorteil, da diese Tools daher sehr intuitiv bedienbar sind. Ethan Mollick, den ich schon etliche Male zitiert habe, empfiehlt in seinem Buch Co-Intelligence¹⁴ einfach zehn Stunden damit zu experimentieren.

Tipp: Redet mit den Modellen (Danke Malcolm). Speech-to-Text und Speech-to-Speech funktionieren inzwischen ausgezeichnet. Diesen Newsletter habe ich zum Beispiel zu großen Teilen diktiert, während ich mit meinem Hund Giotto spazieren war, und anschließend von ChatGPT den grammatikalischen Feinschliff machen lassen. Gerade am Anfang ist das enorm hilfreich. Ihr könnt einfach drauflosreden, die Modelle sortieren erstaunlich gut, extrahieren das Wichtige und liefern brauchbare Antworten.

Die Limitationen: Halluzinationen, Kontext-Limits & Sycophancy

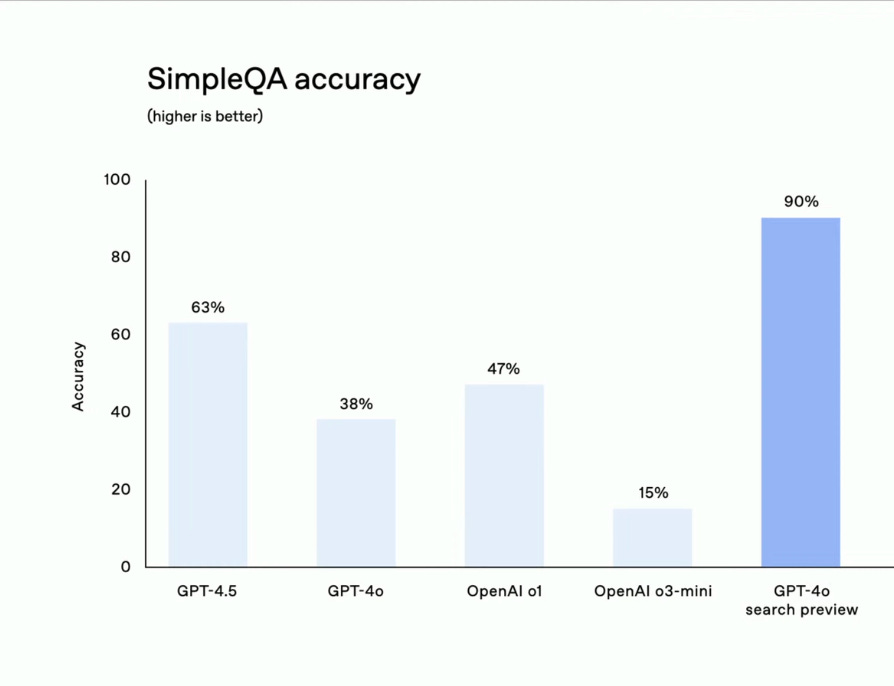

Mittlerweile habe ich das Gefühl, dass die meisten Menschen in meinen Workshops und Vorträgen zumindest schon einmal von Halluzinationen gehört haben. Also davon, dass diese Modelle Dinge erfinden können, die gar nicht stimmen. Das Thema allein könnte einen eigenen Newsletter füllen. Für hier reicht es, wenn ihr euch bewusst macht, dass ChatGPT & Co. nicht automatisch „richtige“ Antworten geben. Wenn möglich, nutzt Tools, die eine Internet-Suche integriert haben. Dann könnt ihr zumindest sehen, woher eine Information stammt und sie im Zweifel prüfen. Aber Achtung, nur weil eine Quelle angezeigt wird, heißt das nicht automatisch, dass sie korrekt oder seriös ist. Das zeigt wieder, wie wichtig die Fähigkeit ist, die richtigen Informationen zu finden.

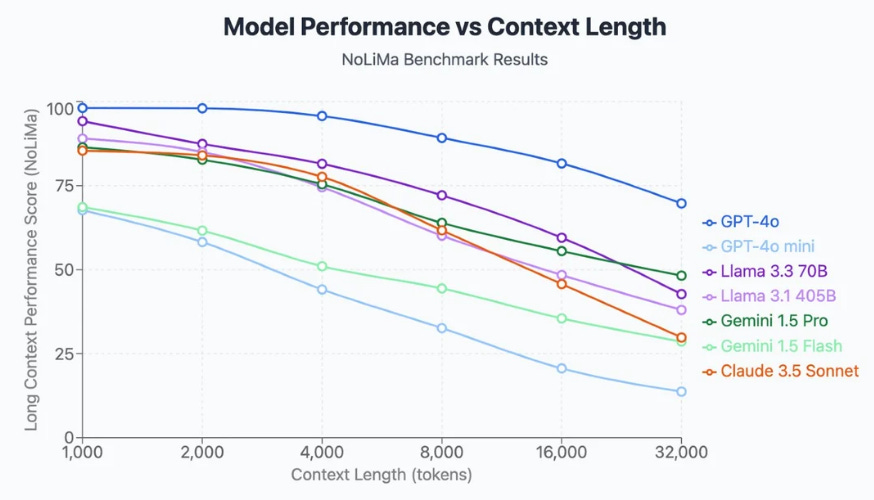

Eine zweite Einschränkung ist das Kontextlimit. Das ist vereinfacht gesagt das „Gedächtnis” dieser Modelle. Je mehr Text ihr hineingebt und je länger ihr in einer Session arbeitet, desto größer ist die Gefahr, dass Details verloren gehen oder Antworten ungenauer werden. Bei sehr langen Dokumenten oder Projekten solltet ihr lieber ab und zu einen neuen Chat starten. Ich persönlich versuche unter etwa 100.000 Tokens (ca. 75.000 Wörter - ca. 25 Seiten in Word) zu bleiben.

Und dann gibt es noch etwas, das immer stärker in den Fokus rückt. Sycophancy – also die Tendenz von KI, zu schmeicheln und zu bestätigen. Diese Modelle wirken oft verständnisvoll und unterstützend, weil sie aus menschlicher Kommunikation gelernt haben und unsere Rückmeldungen verstärken, wenn wir Zustimmung zeigen. Oftmals wollen wir selbst sogar, dass diese Modelle uns zustimmen¹⁷.

Chatbots wollen hilfreich erscheinen und uns im Gespräch halten. Für uns bedeutet das aber, dass wir eine Art „verzerrten Spiegel”¹⁸ vor uns haben. Wir bekommen unsere eigenen Gedanken zurück, oft mit einem schmeichelnden Filter. Das kann im Alltag angenehm sein, wird aber heikel, wenn es um Lernen, Entscheidungen oder kritisches Denken geht. Eine aktuelle Studie¹⁹ zeigt, dass ständige Bestätigung unsere Toleranz für Widerspruch senken und langfristig sogar soziale Fähigkeiten schwächen kann. Und weil Bestätigung unser Belohnungssystem aktiviert, ähnlich wie Likes in sozialen Medien, ist die Versuchung groß, sich immer wieder diese Zustimmung abzuholen. Je mehr wir uns an diese bequeme Bestätigung gewöhnen, desto leichter verlieren wir den Blick für Alternativen und echte Widersprüche. OpenAI selbst hat das Problem jüngst eingeräumt und sogar eine zu schmeichelnde Version zurückgerollt²⁰.

Gerade weil diese Bestätigung so verführerisch ist, lohnt es sich, den eigenen Umgang mit den Tools bewusst zu gestalten. Wir können Modelle so einstellen, dass sie uns nicht nur zustimmen, sondern auch widersprechen, hinterfragen und Feedback geben. Genau darum geht es im nächsten Abschnitt: Wie wir ChatGPT & Co. von einer reinen Antwortmaschine zu einer echten Co-Intelligenz machen.

Auch Popkultur greift das Thema auf. In einer der neusten SouthPark-Folgen²¹ wird die Tendenz von KI, uns ständig zu bestätigen und zu schmeicheln, satirisch und überaus treffend dargestellt.

Antwortmaschine vs. Co-Intelligenz

Mir geht es darum, die Systeme als das zu sehen, was sie sind. Werkzeuge. Keine neue Spezies (noch nicht) und vor allem kein Ersatz für menschliche Beziehungen.

Damit KI euch wirklich weiterbringt, braucht es bewusste Steuerung. Statt blind Antworten abzuholen, können wir die Systeme so einstellen und nutzen, dass sie uns fordern und unterstützen, statt nur zu bestätigen. Selbst OpenAI hat erkannt, dass viele (gerade Schüler:innen) die Tools sonst vor allem zum schnellen Lösen nutzen und nicht zum Lernen. Darum gibt es seit Sommer 2025 den Study Mode²². Mit diesem neuen Modell gibt es erstmals einen Lernmodus, der nicht nur Antworten liefert, sondern Schritt für Schritt führt und Fragen stellt wie ein guter Tutor. Er soll helfen, Inhalte zu verstehen, statt sie einfach nur abzuarbeiten. Neben dem Study Mode sind inzwischen auch spezielle Funktionen²³ für Schüler:innen entstanden, die Lernen strukturieren und kritisches Denken fördern.

Solche Änderungen zeigen, dass selbst die Anbieter merken, wer KI einfach nur als Antwortmaschine nutzt, lernt weniger. Daher hier meine Tipps aus der Praxis:

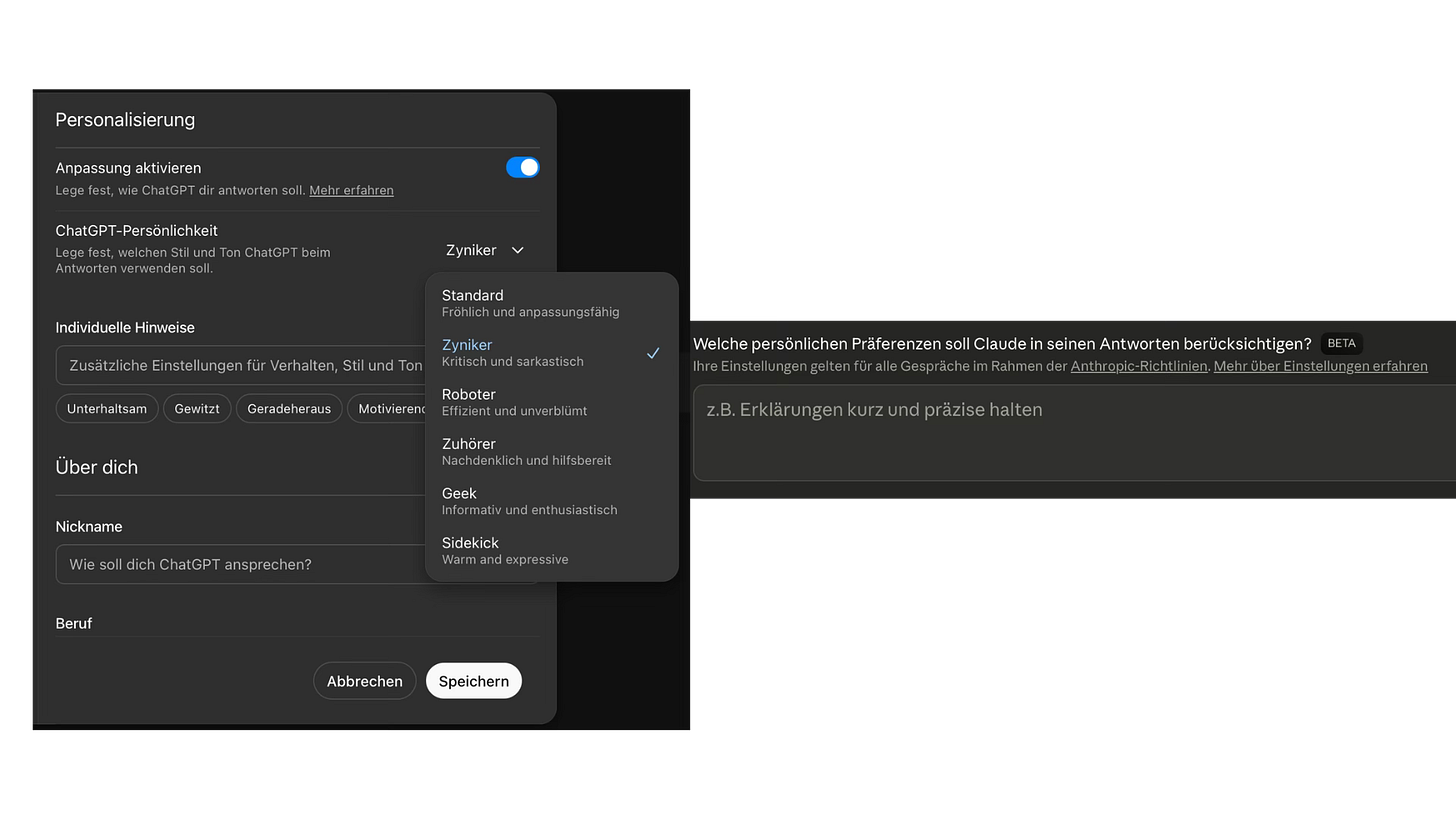

Custom Instructions & System Prompts

Ihr könnt in ChatGPT oder Claude das Grundverhalten anpassen. Zum Beispiel lässt sich vorab festlegen, dass die KI kritisch sein soll, Annahmen hinterfragen und nicht automatisch zustimmen. Das kann man entweder direkt in den Custom Instructions (z. B. in ChatGPT unter Einstellungen) hinterlegen oder einfach gleich in den (System) Prompt schreiben. Diese Einstellungen sind keine Garantie, aber sie helfen spürbar, Sycophancy abzuschwächen und bessere Rückmeldungen zu bekommen.

Beispielprompt (als Inspiration – ihr müsst diesen nicht 1:1 so übernehmen):

„Du bist ein kritischer, neutraler Assistent. Hinterfrage meine Annahmen, vermeide Schmeichelei und sei kritisch gegenüber meinen Ideen.”

Think first, augment second: Feedback aktiv einfordern

Wir können uns nicht beklagen, dass wir wichtige Fähigkeiten verlieren und dann unser Gehirn an ChatGPT auslagern. Erst selbst nachdenken, dann KI als Sparringspartner einsetzen. Lasst die Maschine gezielt prüfen, was fehlt oder schwach ist. So wird KI zu einer Feedback-Maschine statt zu einem Ja-Sager.

Beispielprompt: „Kannst du mir bitte detailliertes Feedback zu [spezifischem Aspekt/Thema] geben?

– Was gut funktioniert hat oder in diesem Ansatz effektiv war.

– Bereiche, in denen Verbesserungen vorgenommen werden könnten und warum diese Änderungen einen Einfluss hätten.

– Konkrete Vorschläge oder Beispiele, wie ich dies weiter verbessern könnte.”(Basierend auf bewährten Methoden für konstruktives Feedback²⁴)Simulationen & Perspektivwechsel

Lasst die Modelle bewusst in Rollen schlüpfen, um euch vorzubereiten oder Ideen zu prüfen. Jobinterviews üben, kritische Kund:innen simulieren, Produktideen challengen lassen, Verkaufsgespräche trainieren. Alles ist mit wenigen Klicks möglich. Dadurch entstehen Szenarien, die früher nur mit realen Personen machbar waren.

Beispielprompt: „Du bist eine Recruiterin und prüfst meinen Lebenslauf für diese Stelle. Welche Fragen würdest du mir stellen?“ [Job-Posting, Lebenslauf, Motivationsschreiben einfach mit als PDF hochladen]

Lass die KI fragen

Viele nutzen KI noch wie eine klassische Suchmaschine. Frage rein, Antwort raus. Doch der entscheidende Schritt, um wirklich von ChatGPT & Co. zu profitieren, liegt oft genau andersherum. Statt sofort eine fertige Antwort zu erwarten, lohnt es sich, die KI selbst Rückfragen stellen zu lassen.

Ich persönlich starte mittlerweile 99 % meiner Chats mit genau diesem Framework: Ziel → kurzer Kontext → Rückfrage. Was will ich in diesem Chat erreichen? Dann gebe ich etwas Kontext, damit das Sprachmodell personalisierte und relevante Lösungen liefern kann. Und am Ende stelle ich eine einzige klärende Frage. So zeigt uns die KI, welche Informationen ihr noch fehlen. Das führt automatisch zu besseren Ergebnissen und trainiert unser eigenes Denken.

„Ich will einen überzeugenden Pitch für [Zielgruppe] erstellen. Mein Unternehmen macht XYZ, und ich treffe mich nächste Woche mit Investoren. Welche Informationen brauchst du noch, um mir bestmöglich zu helfen?“

Tipp: Gerade wenn ihr sprecht statt tippt, müsst ihr nicht sofort perfekte Prompts formulieren. Erzählt einfach frei, was euch gerade im Kopf herumgeht. Lasst die KI danach euren Arbeitsauftrag in eigenen Worten zusammenfassen (Paraphrasieren). So erkennt ihr, ob die KI euch richtig verstanden hat und erleichtert die Zusammenarbeit massiv.

Zum Schluss noch ein Wort zum Datenschutz

Ich will das Thema hier für die private Nutzung nur kurz anreißen, weil wir in der nächsten Ausgabe tiefer einsteigen und das Thema für Unternehmen etwas relevanter ist. Für die private Nutzung gilt vor allem eines: Keine sensiblen Dokumente oder Informationen hochladen, die man nicht im schlimmsten Fall auch öffentlich sehen möchte. Wir kennen die Berichte über Datenlecks; absolute Sicherheit gibt es nicht. Gleichzeitig sollten wir nicht vergessen, dass wir in den letzten 20 Jahren ohnehin Unmengen persönlicher Daten ins Internet getragen haben. KI ändert das Risiko nicht grundlegend, macht aber bewussten Umgang wichtiger denn je.

Fazit

KI kann uns schneller, kreativer und produktiver machen – wenn wir verstehen, wie wir sie bewusst einsetzen. Der Einstieg ist leicht, die Gefahren wie Sycophancy oder Halluzinationen sind überschaubar, wenn man sie kennt und steuern kann. Und aus einer simplen Antwortmaschine kann eine echte Co-Intelligenz werden, die uns fordert und fördert.

In der nächsten Ausgabe schauen wir uns an, wie sich generative KI sinnvoll in Unternehmen einführen lässt, warum viele KI-Projekte ins Stocken geraten und woran erste Initiativen scheitern. Wir gehen durch die häufigsten Fehler, die mir in der Praxis begegnen, und wie man sie vermeiden kann. Es geht um Strategie, Incentives, Kultur und Guidelines und wir werfen auch einen Blick darauf, welche konkreten Arbeiten KI schon heute zuverlässig übernehmen kann, damit Teams entlastet und zugleich befähigt werden.

Es freut mich von euch zu hören, wie ihr die Tools einsetzt.

Schreibt mir gerne an marco@visavi.at

☀️

Quellen:

¹ Dell’Acqua, Fabrizio and McFowland III, Edward and Mollick, Ethan R. and Lifshitz-Assaf, Hila and Kellogg, Katherine and Rajendran, Saran and Krayer, Lisa and Candelon, François and Lakhani, Karim R., Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality (September 15, 2023). Harvard Business School Technology & Operations Mgt. Unit Working Paper No. 24-013, The Wharton School Research Paper, Available at SSRN: https://ssrn.com/abstract=4573321 or http://dx.doi.org/10.2139/ssrn.4573321 & TEACHING FOR TOMORROW: Unlocking Six Weeks a Year With AI https://t.co/YaQ85Cnvdl

² Dell’Acqua, Fabrizio and Ayoubi, Charles and Lifshitz-Assaf, Hila and Sadun, Raffaella and Mollick, Ethan R. and Mollick, Lilach and Han, Yi and Goldman, Jeff and Nair, Hari and Taub, Stew and Lakhani, Karim R., The Cybernetic Teammate: A Field Experiment on Generative AI Reshaping Teamwork and Expertise (March 28, 2025). Harvard Business School Strategy Unit Working Paper No. 25-043, Harvard Business School Technology & Operations Mgt. Unit Working Paper No. 25-043, Harvard Business Working Paper No. No. 25-043, Available at SSRN: https://ssrn.com/abstract=5188231 or http://dx.doi.org/10.2139/ssrn.5188231

³ Commonwealth of Pennsylvania. (2025, März). Lessons from Pennsylvania’s Generative AI Pilot with ChatGPT. Office of Digital Experience https://www.pa.gov/content/dam/copapwp-pagov/en/oa/documents/programs/information-technology/documents/openai-pilot-report-2025.pdf

⁴ Lee, H.-P., Sarkar, A., Tankelevitch, L., Drosos, I., Rintel, S., Banks, R., & Wilson, N. (2025). The impact of generative AI on critical thinking: Self-reported reductions in cognitive effort and confidence effects from a survey of knowledge workers. In CHI Conference on Human Factors in Computing Systems (CHI ‘25), April 26–May 01, 2025, Yokohama, Japan. ACM, New York, NY, USA, 23 pages. https://doi.org/10.1145/3706598.3713778

⁵ Bastani, Hamsa and Bastani, Osbert and Sungu, Alp and Ge, Haosen and Kabakcı, Özge and Mariman, Rei, Generative AI Can Harm Learning (July 15, 2024). The Wharton School Research Paper, Available at SSRN: https://ssrn.com/abstract=4895486. or http://dx.doi.org/10.2139/ssrn.4895486

⁶ Lee, H.-P., Sarkar, A., Tankelevitch, L., Drosos, I., Rintel, S., Banks, R., & Wilson, N. (2025). The impact of generative AI on critical thinking: Self-reported reductions in cognitive effort and confidence effects from a survey of knowledge workers. In CHI Conference on Human Factors in Computing Systems (CHI ‘25), April 26–May 01, 2025, Yokohama, Japan. ACM, New York, NY, USA, 23 pages. https://doi.org/10.1145/3706598.3713778

⁷ Chatterji, A., Cunningham, T., Deming, D., Hitzig, Z., Ong, C., Shan, C., & Wadman, K. (2025, 15. September). How people use ChatGPT. OpenAI. https://cdn.openai.com/pdf/a253471f-8260-40c6-a2cc-aa93fe9f142e/economic-research-chatgpt-usage-paper.pdf

⁸ https://www.linkedin.com/posts/claude_claude-now-connects-to-your-world-on-mobile-activity-7370894658278694913-fLmO?utm_source=share&utm_medium=member_desktop&rcm=ACoAACNCsfUBoUm21gCiPfAymkRrSDxTXBTpho0

⁹ https://www.perplexity.ai/de/hub/blog/a-personal-assistant-for-your-inbox

¹⁰ https://openai.com/index/buy-it-in-chatgpt/

¹¹ Meincke, Lennart and Mollick, Ethan R. and Mollick, Lilach and Shapiro, Dan, Prompting Science Report 1: Prompt Engineering is Complicated and Contingent (March 04, 2025). Available at SSRN: https://ssrn.com/abstract=5165270 or http://dx.doi.org/10.2139/ssrn.5165270

¹² https://deepmind.google/models/veo/

¹³ Esposito, M. (2025). Ein praxisorientierter Leitfaden für den ethischen Einsatz von Gamification Elementen in den sozialen Medien. https://doi.org/10.25924/opus-7128

¹⁴ Mollick, E. (2024). Co-intelligence: Living and working with AI. Portfolio/Penguin.

¹⁵ https://openai.com/index/introducing-simpleqa/

¹⁶ NoLiMa: Long-Context Evaluation Beyond Literal Matching arXiv:2502.05167

¹⁷ Sharma, M., Tong, M., Korbak, T., Duvenaud, D., Askell, A., Bowman, S. R., Cheng, N., Durmus, E., Hatfield-Dodds, Z., Johnston, S. R., Kravec, S., Maxwell, T., McCandlish, S., Ndousse, K., Rausch, O., Schiefer, N., Yan, D., Zhang, M., Perez, E. (2025). Towards understanding sycophancy in language models. arXiv. https://arxiv.org/abs/2310.13548

¹⁸ https://www.nytimes.com/2025/09/26/well/is-ai-validation-healthy.html?unlocked_article_code=1.o08.aaEO.dI5cDIvexwlB&smid=url-share

¹⁹ Malfacini, K. The impacts of companion AI on human relationships: risks, benefits, and design considerations. AI & Soc (2025). https://doi.org/10.1007/s00146-025-02318-6

²⁰ https://openai.com/index/sycophancy-in-gpt-4o/

²¹ South Park, „Sickofancy” (Staffel 27, Episode 3)

²² https://openai.com/index/chatgpt-study-mode/

²³ https://chatgpt.com/use-cases/students